「雨宿りの木」科学的介護の実現に向けて、現在の進捗とこれからの活動 開催レポート(前編)

会員専用ページの閲覧にはパスワードが必要です。ログインはこちらから。

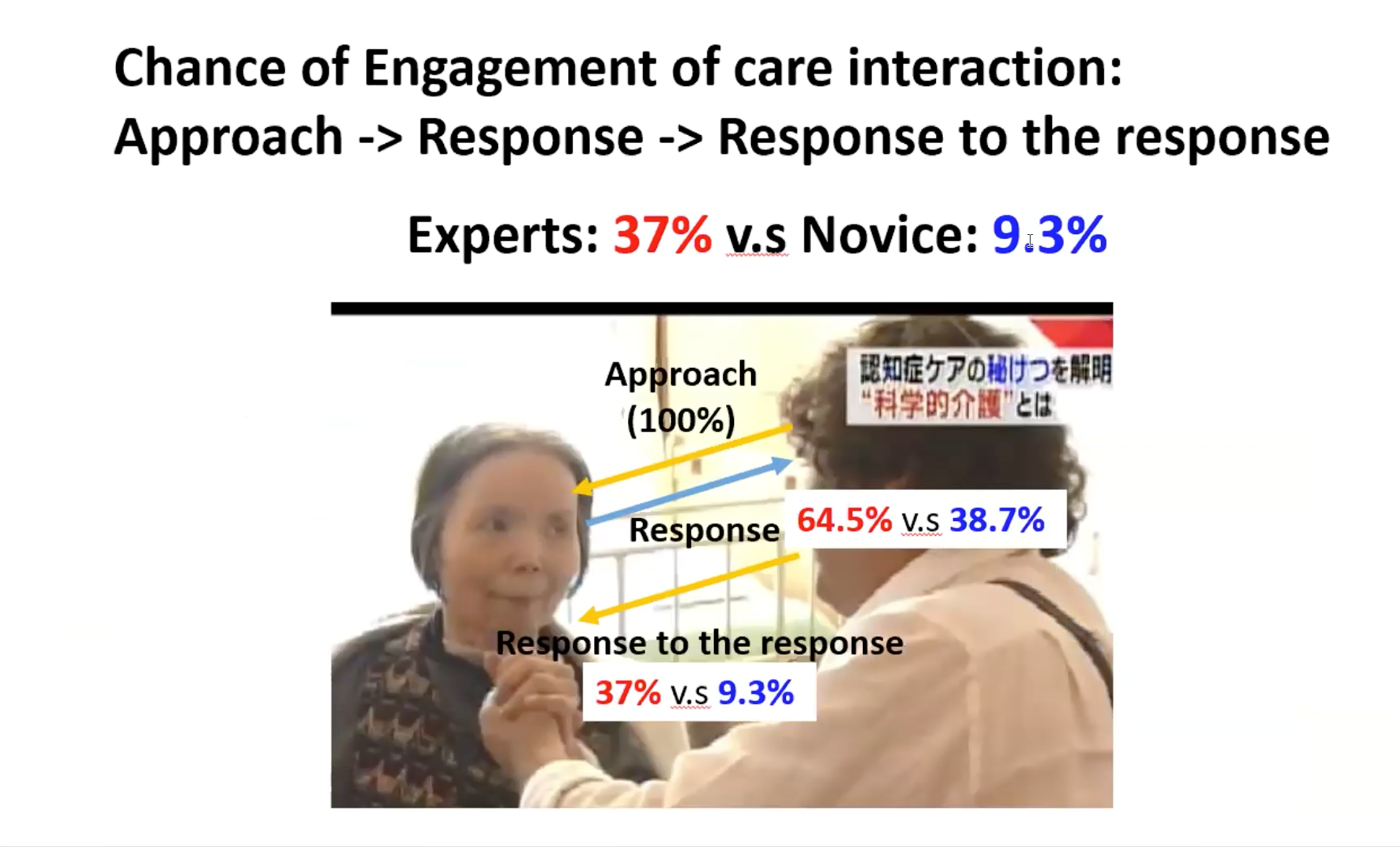

会員コミュニティ「雨宿りの木」にて、8月に行われたオンライン勉強会「科学的介護の実現に向けて、現在の進捗とこれからの活動」の模様をご紹介します。ゲストは当学会の理事でもある京都大学大学院情報学研究科の中澤篤志准教授。中澤先生が代表となり進められているユマニチュードの科学的な分析、人工知能やロボットを使った共同研究とは、そしてそこから広がる「優しいケア」について、本田美和子代表理事と語っていただきました。

このコンテンツは、会員専用です。

会員の方は、こちらからログインし、記事をご覧下さい。

会員登録をご希望の方

『入会のご案内』ページをご覧ください。